Apple xác nhận sẽ dừng kế hoạch triển khai CSAM - Phát hiện tài liệu xâm hại tình dục trẻ em

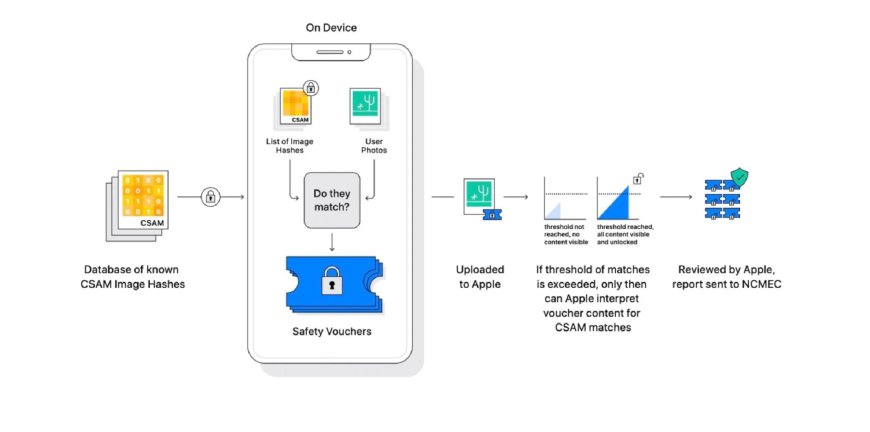

CSAM hay Child Sexual Abuse Material - phát hiện tài liệu xâm hại tình dục trẻ em là một tính năng được Apple phát triển dành cho iCloud Photos, tuy nhiên khi những thử nghiệm đầu tiên được triển khai, Apple đã vấp phải sự phản đối, lo ngại về quyền riêng tư và cuối cùng họ đã phải dừng phát triển nó.

Đây là tuyên bố của Phó chủ tịch phần mềm Craig Federighi trong một buổi phỏng vấn với WSJ. Khi CSAM được công bố, iCloud Photos có thể phát hiện nội dung không phù hợp với trẻ em bằng phương pháp băm (hash) cơ sở dữ liệu CSAM. Bằng cách này, Apple có thể xử lý những bức ảnh xấu ngay trên thiết bị mà không cần phải xem ảnh của người dùng.

Nhưng đáng tiếc là nó vấp phải sự phản đối từ nhiều phía, Apple cho biết họ cần thời gian để thu thập thêm cơ sở dữ liệu để phục vụ cho việc vận hàng trơn tru, thế rồi họ phải dừng lại.

Theo 9to5Mac.

Bạn nghĩ sao ?

thích

0

thích

0

Không thích

0

Không thích

0

Love

0

Love

0

Funny

0

Funny

0

Angry

0

Angry

0

Sad

0

Sad

0

Wow

0

Wow

0